DL_PyTorch

1.7K Views

November 28, 24

スライド概要

医学生。AIや業務・学習効率化に興味あり。

関連スライド

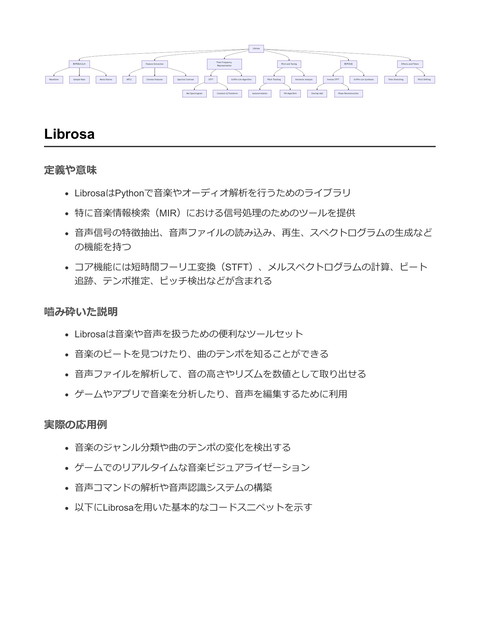

SP_Librosa

各ページのテキスト

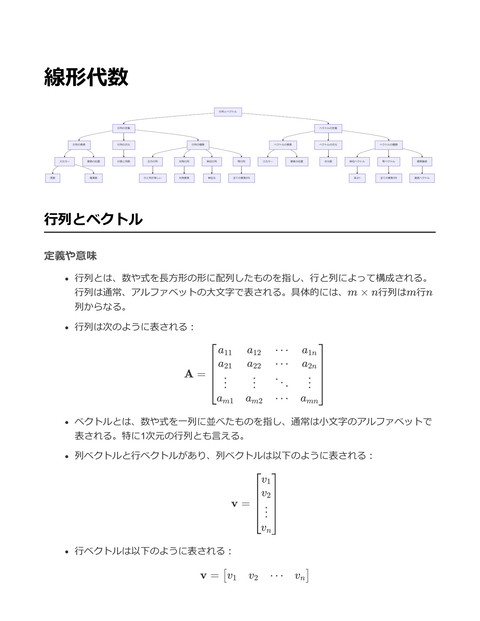

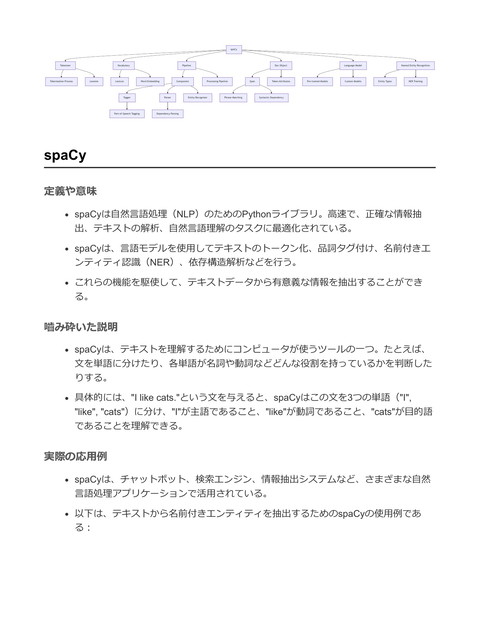

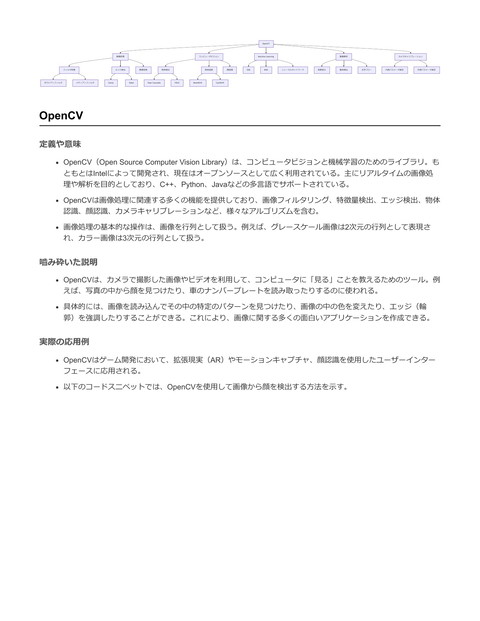

PyTorch Tensor Tensor Operations Autograd CUDA Tensors Computational Graph torch.nn Gradient Descent Forward Method Module torch.optim Sequential Loss Function SGD DataLoader Adam Batch Processing Dataset Data Augmentation Custom Dataset Transforms Backward Method PyTorch 定義や意味 PyTorchは、Facebookによって開発されたオープンソースの機械学習ライブラリ。主 にディープラーニングの開発と研究に用いられる。PyTorchの特徴として、動的計算 グラフの構築、Pythonと深く統合された使い勝手の良いAPI、高度なGPUサポートな どが挙げられる。 PyTorchはテンソル(多次元配列)を基本データ構造として用いる。テンソルは数値 計算を効率的に行うための構造であり、数式で表すと次のようになる: スカラー(0次元):x ∈ R ベクトル(1次元):v ∈ Rn 行列(2次元):M ∈ Rm×n テンソル(n次元):T ∈ Rd1 ×d2 ×⋯×dn 嚙み砕いた説明 PyTorchは機械学習、特にディープラーニングのモデルを作るための便利なツール。 Pythonと統合されているので、Pythonのコードに慣れている人には使いやすい。 PyTorchの最大の特徴は、計算グラフを動的に構築できること。これは、計算の流れ をリアルタイムで変更できるということを意味し、デバッグやプロトタイピングが非 常に容易になる。 例えば、テンソルというデータ型は、単なる数値の配列と考えて良い。1次元のテン ソルはリストのようなもので、2次元のテンソルは行列のようなもの。これを使っ て、数値計算やデータの操作を簡単に行うことができる。 実際の応用例 PyTorchは多くのディープラーニングモデルの開発に用いられている。特に、コンピ ュータビジョンや自然言語処理の分野で広く利用されている。

以下は、PyTorchを用いて単純なニューラルネットワークを定義し、データを用いて 学習する例: import torch import torch.nn as nn import torch.optim as optim # 定義:単純な線形回帰モデル class SimpleLinearRegression(nn.Module): def __init__(self): super(SimpleLinearRegression, self).__init__() self.linear = nn.Linear(1, 1) def forward(self, x): return self.linear(x) # データ x_train = torch.tensor([[1.0], [2.0], [3.0], [4.0]]) y_train = torch.tensor([[2.0], [4.0], [6.0], [8.0]]) # モデル初期化 model = SimpleLinearRegression() # 損失関数とオプティマイザ criterion = nn.MSELoss() optimizer = optim.SGD(model.parameters(), lr=0.01) # トレーニングループ for epoch in range(1000): model.train() optimizer.zero_grad() outputs = model(x_train) loss = criterion(outputs, y_train) loss.backward() optimizer.step() if (epoch+1) % 100 == 0: print(f'Epoch [{epoch+1}/1000], Loss: {loss.item():.4f}') このコードでは、1次元のデータを用いた単純な線形回帰モデルを構築している。 PyTorchを利用することで、モデルの定義、損失関数の設定、オプティマイザの選 択、そして学習ループの実行が非常に簡単に行える。

Tensor 定義や意味 テンソルは、多次元配列を一般化したもので、スカラー(0次元)、ベクトル(1次 元)、行列(2次元)などを含む高次元のデータ構造。数学的には、テンソルは座標 変換に対して特定の変換法則に従うオブジェクト 例えば、3次元テンソルは3方向にインデックスを持つ配列として表現。テンソルの階 数(ランク)はその次元の数を表す テンソルの要素 ai1 ,i2 ,…,in は、n 個の添字を持つ 嚙み砕いた説明 テンソルは、数字の箱のようなもので、さまざまな次元を持つデータを扱うことがで きる。例えば、画像を扱う際には3次元テンソルを用いることが多く、画像の幅、高 さ、色チャネルをテンソルの次元として表す ベクトルや行列を拡張し、より多くの次元を持つデータを効果的に扱えるようにする ための構造 PythonのライブラリであるPyTorchでは、テンソルを使ってニューラルネットワーク の入力データや重みを表現する 実際の応用例 テンソルはディープラーニングのフレームワーク(例えばPyTorchやTensorFlow)で 広く使用されている。特にニューラルネットワークの重みやバイアス、入力データや 中間層の出力を表現するために使用される 画像処理や自然言語処理など、さまざまなAI/ML分野でデータを表現するための基本 的なデータ構造としてよく用いられる

import torch # 1次元のテンソル(ベクトル) vector = torch.tensor([1, 2, 3]) # 2次元のテンソル(行列) matrix = torch.tensor([[1, 2, 3], [4, 5, 6]]) # 3次元のテンソル(例えば画像データ) image_tensor = torch.rand((3, 224, 224)) # 3つのカラーチャネル、224x224の画像 # テンソルの操作例 # テンソルの形状を取得 shape = image_tensor.shape # Returns: torch.Size([3, 224, 224]) # テンソルの要素にアクセス element = image_tensor[0, 0, 0] # 1つ目のチャネルの1行目1列目のピクセル値 # テンソル同士の加算 sum_tensor = vector + vector # 要素毎の加算 上記のコードスニペットでは、PyTorchを用いてテンソルを作成、操作する基本例を 示す。テンソルの形状や要素へのアクセス、基本的な数学操作を行う例を提供 Autograd 定義や意味 Autogradは自動微分の略称であり、計算グラフを用いて関数の微分を自動的に計算す る手法 主に機械学習において、勾配降下法を用いた最適化のプロセスで利用される PyTorchでは、テンソルの演算を追跡し、その演算のグラフを構築することで自動的 に微分を計算する 計算グラフの各ノードはテンソルであり、エッジはそれらの間の演算を表す 微分は逆伝播(backpropagation)を通じて計算される 嚙み砕いた説明 Autogradは、機械学習モデルのトレーニング中に必要な微分を自動で計算する機能

通常、手動で計算するのは難しい、もしくは面倒な複雑な関数の微分を、プログラム が自動でやってくれる PyTorchでは、テンソルに対して演算を行うと、その操作が記録され、後で微分を計 算するために使われる 例えば、損失関数の値を最小化するために、各パラメータに対する損失の勾配を求め る必要があるが、Autogradを使えば自動で計算される 実際の応用例 Autogradはニューラルネットワークのトレーニングにおいて、誤差逆伝播法 (backpropagation)を実装する際に広く使われる モデルのパラメータを更新するための勾配計算を自動で行うことで、開発者はモデル の設計に集中できる 以下はPyTorchでのAutogradの基本的な使い方の例: import torch # テンソルを定義し、微分が必要な場合はrequires_grad=Trueを指定 x = torch.tensor(2.0, requires_grad=True) # 関数y = x^2を定義 y = x ** 2 # yの勾配を計算(dy/dx) y.backward() # xに対する微分(勾配)を出力 print(x.grad) # 出力: tensor(4.) この例では、y = x2 の微分を計算し、結果として dy/dx = 2x であり、x = 2 の ときの勾配は 4 であることが示される Autogradは、特に複雑なニューラルネットワークの勾配計算を簡単にするために非常 に有用

torch.nn 定義や意味 torch.nn は、PyTorchライブラリにおけるニューラルネットワーク(NN)モジュー ルの構成要素を提供するサブモジュール ニューラルネットワークの層(レイヤー)や損失関数、活性化関数、その他のユーテ ィリティを含む torch.nn は高レベルのAPIを提供し、ニューラルネットワークの構築とトレーニング を簡素化する ニューラルネットワークの基本単位である層は torch.nn.Module を継承して作成する 嚙み砕いた説明 torch.nn は、PyTorchを使って機械学習モデル、特にニューラルネットワークを作成 するためのツールセット 各層(例えば、全結合層や畳み込み層)は torch.nn 内のクラスとして定義されてお り、これを使ってモデルを組み立てる 層の組み合わせや構造を定義し、学習のための損失関数や最適化手法を選ぶ torch.nn を使うことで、手動で重みやバイアスを管理する手間が省ける 実際の応用例 torch.nn は、ディープラーニングモデル(例:CNN、RNN、DNNなど)の構築に広 く使用されている 以下に、シンプルな全結合ニューラルネットワークを作成する例を示す

import torch import torch.nn as nn import torch.optim as optim # サンプルのニューラルネットワーク定義 class SimpleNN(nn.Module): def __init__(self, input_size, hidden_size, output_size): super(SimpleNN, self).__init__() self.fc1 = nn.Linear(input_size, hidden_size) self.relu = nn.ReLU() # 入力から隠れ層への全結合層 # 活性化関数ReLU self.fc2 = nn.Linear(hidden_size, output_size) # 隠れ層から出力への全結合層 def forward(self, x): out = self.fc1(x) out = self.relu(out) out = self.fc2(out) return out # モデルのインスタンス化 input_size = 784 # 例としてMNISTデータセットの入力サイズ hidden_size = 500 output_size = 10 # MNISTは0-9の10クラス分類 model = SimpleNN(input_size, hidden_size, output_size) # 損失関数と最適化手法の設定 criterion = nn.CrossEntropyLoss() # クロスエントロピー損失 optimizer = optim.SGD(model.parameters(), lr=0.01) # 確率的勾配降下法 # サンプルのトレーニングループ # データローダーから入力データとラベルを取得した場合 # for epoch in range(num_epochs): # for inputs, labels in data_loader: # outputs = model(inputs) # loss = criterion(outputs, labels) # optimizer.zero_grad() # loss.backward() # optimizer.step() このコードスニペットでは、 torch.nn を用いて基本的なニューラルネットワークを構 築し、トレーニングの枠組みを示す 各層は nn.Linear を使って定義し、活性化関数として nn.ReLU() が使用されている

損失関数として nn.CrossEntropyLoss() 、最適化手法として optim.SGD を使用している torch.optim 定義や意味 torch.optim はPyTorchにおける最適化アルゴリズムを提供するモジュール 機械学習モデルの訓練において、損失関数を最小化するためのパラメータ更新手法を 実装 勾配降下法の変種を含む様々な最適化アルゴリズムをサポートし、学習率やモーメン タムなどのハイパーパラメータ設定を容易にする 例えば、最急降下法(SGD: Stochastic Gradient Descent)は下記のようにモデルの パラメータ θ を更新する θ = θ − η∇L(θ) ここで、η は学習率、∇L(θ)は損失関数の勾配 嚙み砕いた説明 torch.optim は、モデルが「もっと良く」なるように、そのパラメータを調整するた めの「計算方法」を提供する 例えば、AIに猫の写真を見せて「これは何?」と聞くとき、そのAIが「犬」と答えた ら、AIの内部を変えて次は正しく答えられるようにする この「どう変えるか」を賢くやるのが、 torch.optim で提供される最適化アルゴリズ ム 学習率はどれくらい大きく変えるかを決めるパラメータで、あまり大きすぎると正し い答えを飛び越えてしまうかもしれない 実際の応用例 torch.optim はディープラーニングモデルを訓練する際に使用される 特に、学習率の調整やモメンタムの導入によって、より効率的にモデルを訓練し、収 束を早める 以下に簡単なニューラルネットワークの訓練ループにおける使用例を示す

import torch import torch.nn as nn import torch.optim as optim # モデルの定義 class SimpleModel(nn.Module): def __init__(self): super(SimpleModel, self).__init__() self.linear = nn.Linear(10, 1) def forward(self, x): return self.linear(x) # モデルのインスタンス化 model = SimpleModel() # 損失関数と最適化アルゴリズムの定義 criterion = nn.MSELoss() optimizer = optim.SGD(model.parameters(), lr=0.01) # 訓練ループ for epoch in range(100): optimizer.zero_grad() # 100エポックの訓練 # 勾配の初期化 outputs = model(torch.randn(10)) # ランダムな入力 loss = criterion(outputs, torch.tensor([1.0])) loss.backward() # 勾配の計算 optimizer.step() # パラメータの更新 # 損失の計算 print(f'Epoch [{epoch+1}/100], Loss: {loss.item():.4f}') # 損失の出力 上記コードスニペットでは、 torch.optim の SGD を使ってモデルのパラメータを更新 optimizer.zero_grad() で勾配を初期化し、 loss.backward() で勾配を計 算、 optimizer.step() でパラメータを更新する流れ 学習率は0.01で設定され、モデルはランダムな入力に対して訓練される

DataLoader 定義や意味 DataLoader は、PyTorchにおけるデータの反復処理を簡便に行うためのクラス。デー タセットからバッチ単位でデータを取り出し、データのシャッフルや並列処理による バッチ生成などをサポートする。 主に機械学習モデルの訓練時に使用され、データセットを効率的に扱うために設計さ れている。 基本的な構造としては、 torch.utils.data.DataLoader クラスを使用し、次のように初 期化する。 DataLoader(dataset, batch_size, shuffle, num_workers) 嚙み砕いた説明 DataLoader は、データを少しずつ(バッチ単位で)処理したいときに使う便利な道 具。例えば、画像やテキストがたくさんある場合、まとめて処理するのではなく、少 しずつ取り出して使うと効率的。 シャッフル機能を使うと、データの順番をランダムにしてくれるので、偏りのない学 習が可能になる。また、複数のCPUコアを使ってデータを取り出すこともできるの で、処理が速くなる。 実際の応用例 画像分類や自然言語処理におけるデータの準備段階で頻繁に使用される。特に大規模 データセットを扱う際に、その効率性は非常に重要。 以下に、MNISTデータセットを DataLoader で読み込む例を示す。

import torch from torch.utils.data import DataLoader from torchvision import datasets, transforms # データセットの前処理を定義 transform = transforms.Compose([ transforms.ToTensor(), transforms.Normalize((0.5,), (0.5,)) ]) # MNISTデータセットをロード train_dataset = datasets.MNIST(root='./data', train=True, transform=transform, download= # DataLoaderを使用してデータセットをバッチに分割 train_loader = DataLoader(dataset=train_dataset, batch_size=64, shuffle=True, num_worker # DataLoaderを使ったデータの反復処理 for images, labels in train_loader: # ここでモデルへの入力や訓練処理を行う pass 上記の例では、 DataLoader を使ってMNISTデータセットをバッチサイズ64でシャッ フルしながら読み込む設定をしている。 num_workers を設定することで、データ読み 込みが非同期で並列化され、パフォーマンスが向上する。 Dataset 定義や意味 データセット(Dataset)とは、データの集合であり、特に機械学習やディープラー ニングにおいてモデルを訓練するためのサンプルデータの集まりを指す。データセッ トは通常、入力データとそれに対応するラベルまたはターゲットから構成される。 データセットは、訓練データセット(training dataset)、検証データセット (validation dataset)、テストデータセット(test dataset)に分割されることが多 い。それぞれ、モデルの学習、チューニング、評価に使用される。 データセットは大きく分けて数値データ、カテゴリーデータ、テキストデータ、画像 データ、音声データなどがある。

嚙み砕いた説明 データセットは、プログラムが「学ぶ」ための材料である。例えば、犬と猫の画像を たくさん集めて、それらをもとに画像認識AIを訓練する場合、これらの画像データの 集まりがデータセットとなる。 データセットは、AIや機械学習モデルが何をするべきかを教えるための教科書のよう なもの。これらのデータをもとに、モデルはパターンを学び、新しいデータに対して も適切な予測ができるようになる。 実際の応用例 データセットは、自然言語処理(NLP)、画像認識、音声認識など、さまざまな分野 の機械学習プロジェクトで利用される。 PyTorchでは、 torch.utils.data.Dataset を継承してカスタムデータセットを作成す ることができる。このクラスはデータセットの抽象クラスであり、 __len__ (データ セットのサイズを返す)と __getitem__ (指定したインデックスのデータを返す)メ ソッドを実装する必要がある。

import torch from torch.utils.data import Dataset class CustomDataset(Dataset): def __init__(self, data, labels): self.data = data self.labels = labels def __len__(self): # データセットのサイズを返す return len(self.data) def __getitem__(self, idx): # 指定したインデックスのデータと対応するラベルを返す sample = self.data[idx] label = self.labels[idx] return sample, label # データとラベルの例 data = torch.randn(100, 3, 32, 32) # 100個の32x32 RGB画像 labels = torch.randint(0, 10, (100,)) # 0から9のラベル # CustomDatasetのインスタンスを作成 dataset = CustomDataset(data, labels) # データセットのサイズを取得 print(f"Dataset size: {len(dataset)}") # データセットの最初のサンプルを取得 sample, label = dataset[0] print(f"Sample shape: {sample.shape}, Label: {label}") この例では、ランダムな画像データとそれに対応するランダムなラベルを持つデータ セットを作成している。 CustomDataset クラスを用いて、データとラベルを管理し、 データセットとして利用できるようにしている。

Tensor Operations 定義や意味 テンソル演算は、テンソルと呼ばれる多次元配列に対して行う数学的操作のこと。テ ンソルはスカラー(0次元)、ベクトル(1次元)、行列(2次元)を拡張したもので あり、任意の次元数を持つことができる。 テンソル演算には、加算、減算、内積、外積、転置、リシェイプ、ブロードキャステ ィングなど、多様な操作が含まれる。 数式で表すと、テンソル A と B の加算は C = A + B で示される。ここで C は A と B の要素ごとの総和を含むテンソル。 嚙み砕いた説明 テンソルは、データを持つ箱のようなもので、箱の中にはたくさんの数値が並んでい る。テンソル演算とは、その箱の中の数値を操作すること。 例えば、2つのテンソルがあるとき、それらを足し合わせると、新しいテンソルがで きる。これはちょうど、2つの同じ形の箱の中の数値を、一つずつ足し合わせるよう なイメージ。 実際の応用例 テンソル演算は、ディープラーニングフレームワークのPyTorchで頻繁に使われる。 モデルの重みの更新、データの前処理、特徴量抽出など、様々な場面で役立つ。 以下に、PyTorchでのテンソル演算の具体例を示す。

import torch # 2つのテンソルを定義 tensor_a = torch.tensor([[1, 2], [3, 4]]) tensor_b = torch.tensor([[5, 6], [7, 8]]) # テンソルの加算 tensor_sum = tensor_a + tensor_b print(tensor_sum) # 出力: # tensor([[ 6, # 8], [10, 12]]) # テンソルの要素ごとの乗算(アダマール積) tensor_mul = tensor_a * tensor_b print(tensor_mul) # 出力: # tensor([[ 5, 12], # [21, 32]]) # テンソルの行列積 tensor_matmul = torch.matmul(tensor_a, tensor_b) print(tensor_matmul) # 出力: # tensor([[19, 22], # [43, 50]]) # テンソルのリシェイプ tensor_reshaped = tensor_a.view(4) print(tensor_reshaped) # 出力: # tensor([1, 2, 3, 4]) 上記のコードスニペットでは、PyTorchを用いてテンソルの加算、要素ごとの乗算、 行列積、リシェイプを行っている。これらの操作は、ニューラルネットワークの計算 やデータの変換において重要な役割を果たす。

CUDA Tensors 定義や意味 CUDA Tensorsとは、NVIDIAのGPUで効率的に計算を行うために設計されたデータ構 造 PyTorchにおいて、CUDA対応のテンソルを使うことで、CPUよりも高速に大規模な 行列計算が可能 CUDA Tensorsは、通常のテンソルと同様に多次元配列を扱うが、GPUのメモリ上に 配置され、CUDAカーネルを利用して並列処理が行われる PyTorchにおいて、テンソルをCUDAに移行する際には、 .cuda() もしく は .to('cuda') メソッドを使用する 嚙み砕いた説明 CUDA Tensorsは、GPUのパワーを活用して計算を高速化するためのツール 通常のテンソルと同じ方法で扱えるが、計算がGPUで行われるため、特に大規模なデ ータや複雑な計算で速度が向上する たとえば、画像認識や自然言語処理のような、深層学習モデルのトレーニングで計算 速度が重要な場合に役立つ 実際の応用例 ディープラーニングにおけるモデルのトレーニングで広く応用される 大規模データセットに対する演算を行うときに、CPUよりもはるかに高速に処理が可 能 以下にPyTorchを用いた簡単なCUDA Tensorsの例を示す:

import torch

# CPU上のテンソルを作成

x_cpu = torch.tensor([1.0, 2.0, 3.0])

print(f"CPU Tensor: {x_cpu}")

# GPU上のテンソルに変換

# 初めにGPUが利用可能か確認する

if torch.cuda.is_available():

x_cuda = x_cpu.to('cuda')

# または x_cpu.cuda()

print(f"CUDA Tensor: {x_cuda}")

else:

print("CUDA is not available.")

# CUDA Tensorを用いて計算

if torch.cuda.is_available():

y_cuda = x_cuda * 2

# テンソルの各要素を2倍

print(f"Result on CUDA: {y_cuda}")

このコードスニペットでは、まずCPU上にテンソルを作成し、それをCUDAに移行してから

計算を行っている。CUDAが利用可能な場合、テンソルの各要素を2倍にする計算がGPU上で

行われる。これにより、計算が高速化される。

Computational Graph

定義や意味

Computational Graph(計算グラフ)は、数学的関数の計算過程を視覚的に表現する

ための有向非巡回グラフ(Directed Acyclic Graph, DAG)

グラフのノードは計算操作や変数を表し、エッジはデータの流れを示す

計算グラフを使うことで、複雑な計算を基本的な演算に分解し、微分や最適化などの

処理を効率よく行うことが可能

例えば、z = x2 + y 2 という関数の計算グラフは以下のようになる

xとy が入力ノード

x2 とy 2 が中間ノード

z が出力ノード

嚙み砕いた説明 計算グラフとは、数学の式を計算する流れを図にしたもの 複数の計算を分解して、それぞれをノードとして表現し、矢印でつないでいく これにより、どの順番で計算が行われ、どのデータがどこに流れていくのかがわかり やすくなる 例えば、複数の数を足したり掛けたりする計算も、計算グラフを使うと、どの数をど のタイミングで演算するのかが明確になる 実際の応用例 計算グラフは、特に深層学習の分野でバックプロパゲーション(誤差逆伝播法)に利 用されている PyTorchでは、自動微分のために計算グラフを動的に構築し、微分を効率的に計算す る import torch # PyTorchにおける計算グラフの例 x = torch.tensor(2.0, requires_grad=True) y = torch.tensor(3.0, requires_grad=True) # 2つの入力から、zを計算 z = x**2 + y**2 # zを計算グラフに基づいてxとyで微分 z.backward() # xとyに対する偏微分を出力 print(x.grad) # 出力: tensor(4.) print(y.grad) # 出力: tensor(6.) このコードでは、z = x2 + y 2 の計算グラフを構築し、z をxとy で微分する requires_grad=True を指定することで、PyTorchは計算グラフを自動的に作成 し、 backward() メソッドを用いて微分を計算する 結果として、xに対する偏微分は4、y に対する偏微分は6として出力される

Gradient Descent 定義や意味 Gradient Descent(勾配降下法)は、最適化アルゴリズムの一つであり、主に機械学 習や最適化問題において関数の極小値を求めるために用いられる手法 このアルゴリズムは、関数の勾配(微分)を利用して、関数の値が最も小さくなる点 に向かって反復的に進む 数学的には、関数 f (x) の極小値を求めたい場合、次の更新式を用いる xk+1 = xk − η∇f (xk ) ここで、xk は k 番目の反復におけるパラメータベクトル、η は学習率(ステップサイ ズ)、∇f (xk ) は f の勾配ベクトル 嚙み砕いた説明 Gradient Descent は、山を下るように、関数の傾きを利用して最も低い地点(最小 値)を見つける方法 山の斜面(勾配)が急であれば、大きく進み、緩やかであれば少し進む 学習率 η は、どれだけ進むかを決めるパラメータであり、大きすぎると極小値を飛び 越えてしまい、小さすぎると収束が遅くなる 実際の応用例 機械学習のモデルの訓練過程で、損失関数を最小化するために使用される ニューラルネットワークの重みを最適化するための基本的な技術 以下は、PyTorchを用いたGradient Descentの簡単な実装例

import torch

# 目的関数の定義(例:二次関数)

def f(x):

return x**2

# 勾配の計算

def gradient(x):

return 2*x

# 初期値の設定

x = torch.tensor(10.0, requires_grad=True)

# ここではx=10から開始

learning_rate = 0.1

# 勾配降下法の反復

for _ in range(100):

# 勾配計算

grad = gradient(x)

# xの更新

x = x - learning_rate * grad

# PyTorchでは勾配の初期化が必要

x.grad = None

print(f'最小値に収束: {x.item()}')

このコードでは、f (x) = x2 という単純な二次関数の最小値を求めるために、Gradient

Descentを適用している。初期値を x = 10 とし、100回の反復で最小値に近づける。

PyTorchを用いて勾配を計算し、更新を行っているが、実際の機械学習モデルでは、損失関数

に対して同様の手法が用いられる。

Module

定義や意味

モジュール(Module)とは、プログラムの機能を分割して管理するための単位を指

す。特に大規模なプログラムやゲーム開発においては、複数の開発者が同時に作業す

るため、機能をモジュールとして分けることで効率的な開発が可能になる。

モジュールは、再利用性、メンテナンス性、可読性を向上させるために設計される。 具体的には、クラスや関数、データ構造などを1つのまとまりとして定義し、他の部 分から独立して動作する。 数学的には、モジュールの概念は集合論や代数的な構造の中で用いられるが、プログ ラミングにおいては主にコードの構造化に関する概念。 嚙み砕いた説明 プログラムを作るとき、全てを一つの大きなファイルに書いてしまうと、後々の修正 が難しくなる。そこで、関連する機能ごとに分けた「箱」を作り、その箱をモジュー ルと呼ぶ。これにより、それぞれの箱を別々に開発したり、修正したりできる。 たとえば、ゲームを作るときに「キャラクターの動き」「敵の動き」「サウンドの管 理」など、機能ごとにモジュールを作成しておくと、各機能を個別に開発することが できる。 実際の応用例 PyTorchにおけるモジュールは、ニューラルネットワークの層やモデル全体を表現す るために使われる。PyTorchの torch.nn.Module クラスは、ニューラルネットワークの コンポーネントを定義し、パラメータの管理や順伝播の計算を行うための基本的な単 位として機能する。 以下に、PyTorchにおける torch.nn.Module を使った簡単なモデルの例を示す。

import torch import torch.nn as nn # 自作のニューラルネットワークモデルを定義するためのクラス class SimpleModel(nn.Module): def __init__(self): super(SimpleModel, self).__init__() # 入力層から隠れ層への線形変換 self.hidden_layer = nn.Linear(10, 5) # 隠れ層から出力層への線形変換 self.output_layer = nn.Linear(5, 1) def forward(self, x): # 順伝播の計算 x = torch.relu(self.hidden_layer(x)) x = self.output_layer(x) # 活性化関数ReLUを適用 # 最後に出力層を通す return x # モデルのインスタンスを作成 model = SimpleModel() # ダミーデータを使って順伝播を実行 input_data = torch.randn(1, 10) # バッチサイズ1、特徴量数10の入力データ output_data = model(input_data) print(output_data) このコード例では、 SimpleModel という名前のクラスを定義し、これ は torch.nn.Module を継承している。このクラスは2つの層(隠れ層と出力層)を持 ち、順伝播を行うための forward メソッドを実装している。これにより、モデルのパ ラメータを管理し、学習の際に使用することができる。 Sequential 定義や意味 Sequential は、深層学習フレームワークPyTorchにおいて、レイヤーを順次に積み重 ねるためのコンテナとして機能するモジュール モデルの各レイヤーを順番に定義し、順次にデータを処理することができる

具体的には、入力から出力までの一連の処理をリストのように定義し、その順番で処 理を行う 数式的には、各レイヤーを fi (x) とし、入力データ x に対する出力は fn (fn−1 (...f2 (f1 (x))...)) で表される 嚙み砕いた説明 Sequential は、複数の処理を順番に行うことができる便利なツール たとえば、画像認識モデルを作るとき、まず画像を小さくするための処理、次に特徴 を抽出する処理、最後に分類する処理、というように、順番に処理を並べることがで きる Sequential を使うと、この一連の流れを簡単に作れる 実際の応用例 画像分類や回帰問題など、基本的なニューラルネットワークモデルの構築に利用され る PyTorchでの簡単なニューラルネットワークモデルの定義に役立つ 以下はPyTorchでの Sequential を使ったニューラルネットワークの定義例: import torch import torch.nn as nn # Sequentialを使ったモデルの定義 model = nn.Sequential( nn.Conv2d(in_channels=1, out_channels=32, kernel_size=3, stride=1, padding=1), # 畳み nn.ReLU(), # 活性化関数 nn.MaxPool2d(kernel_size=2, stride=2), # プーリング層 nn.Conv2d(in_channels=32, out_channels=64, kernel_size=3, stride=1, padding=1), # 畳 nn.ReLU(), # 活性化関数 nn.MaxPool2d(kernel_size=2, stride=2), # プーリング層 nn.Flatten(), # 平坦化 nn.Linear(64 * 7 * 7, 128), # 全結合層 nn.ReLU(), # 活性化関数 nn.Linear(128, 10) # 出力層 ) # モデルの概要を表示 print(model)

上記のコードは、畳み込みニューラルネットワーク(CNN)を順次に定義している 各レイヤーは Sequential コンテナに順番に追加されており、入力データは順次にこれ らのレイヤーを通過していく Loss Function 定義や意味 損失関数(Loss Function)とは、機械学習モデルの予測結果と実際の値との不一致の 度合いを定量化するための関数 目的は、モデルの学習過程で重みを最適化し、予測精度を向上させること 損失関数の値を最小化することで、モデルの精度を向上させる 数式として、一般的な損失関数の例には二乗誤差(MSE: Mean Squared Error)があ る MSE = n1 ∑ni=1 (yi − y^i )2 ここで、nはサンプル数、yi は実際の値、y ^i は予測値 嚙み砕いた説明 損失関数は、予測がどれだけ間違っているかを数値で示すもの 例えば、家の価格を予測するモデルがあり、そのモデルが予想した価格と実際の価格 の差を計算する 差が大きければ大きいほど、モデルの予測が悪いと評価される この「差」をできるだけ小さくしていく過程が、モデルを訓練すること 実際の応用例 機械学習モデルの訓練時に、損失関数はモデルのパラメータ(重み)を調整するため に用いられる PyTorchを使ってニューラルネットワークモデルを構築するとき、損失関数はモデル の出力とラベルとの誤差を計算する 例として、PyTorchでのMSE損失関数の使用法を示す

import torch

import torch.nn as nn

# 予測値と実際の値

predictions = torch.tensor([2.5, 0.0, 2.1, 7.8])

targets = torch.tensor([3.0, -0.5, 2.0, 7.0])

# MSELoss関数の定義

mse_loss = nn.MSELoss()

# 損失の計算

loss = mse_loss(predictions, targets)

print(f'MSE Loss: {loss.item()}')

このコードスニペットでは、PyTorchの nn.MSELoss が使われ、予測値と実際の値の間

の二乗誤差を計算

loss.item() で損失値を取得し、モデルの性能評価に使用する

SGD(Stochastic Gradient Descent)

定義や意味

SGD(確率的勾配降下法)は、最適化アルゴリズムの一種で、特に機械学習や深層学

習におけるモデルの学習に用いられる手法。勾配降下法の一種であり、大規模データ

セットに対して効率的に適用できる特徴を持つ。SGDはデータセット全体ではなく、

ランダムに選ばれた1つまたは少数のデータサンプルに基づいてモデルのパラメータ

を更新する。

基本的なSGDの更新式は以下の通り:

θt+1 = θt − η∇θ L(θt ; xi , yi )

ここで、θt はt番目の更新におけるパラメータベクトル、η は学習率、L(θ; xi , yi )は損失関

数、∇θ L(θt ; xi , yi )は損失関数のパラメータθ に関する勾配。

嚙み砕いた説明

SGDは、大規模なデータセットを扱う際に計算コストを抑えるため、データセット全

体ではなく、ランダムに選んだ一部のデータを使ってモデルのパラメータを更新する

方法。これにより、モデルの訓練が高速に行える。

例えば、全てのデータを使って重い計算をする代わりに、ランダムに選ばれたひとつ のデータだけを使って計算し、それに基づいてパラメータを少しずつ更新していくこ とで、徐々にモデルを最適化していくという考え方。 実際の応用例 SGDは、特にディープラーニングの分野で重用され、多くのフレームワークで実装さ れている。例えば、PyTorchはSGDを簡単に使用できるようにしている。 以下にPyTorchを用いたSGDの使用例を示す: import torch import torch.nn as nn import torch.optim as optim # シンプルな線形モデル model = nn.Linear(10, 1) # 損失関数 criterion = nn.MSELoss() # SGDオプティマイザー optimizer = optim.SGD(model.parameters(), lr=0.01) # ダミーデータ inputs = torch.randn(10) targets = torch.randn(1) # 一回の学習ステップ optimizer.zero_grad() # 勾配をゼロに初期化 outputs = model(inputs) # フォワードパス loss = criterion(outputs, targets) # 損失計算 loss.backward() # バックプロパゲーション optimizer.step() # パラメータ更新 このコードは、PyTorchのSGDオプティマイザーを使って簡単な線形モデルを訓練する 例。 optimizer.step() を呼び出すことで、SGDによるパラメータ更新が行われる。

Adam 定義や意味 Adamは「Adaptive Moment Estimation」の略で、ディープラーニングにおける最適化 アルゴリズムの一つ 確率的勾配降下法(SGD)をベースに、学習率の調整を適応的に行う手法 勾配の一次モーメント(平均)と二次モーメント(分散)を利用して、各パラメータ の更新を行う 更新則は以下のように定義される mt = β1 mt−1 + (1 − β1 )gt vt = β2 vt−1 + (1 − β2 )gt2 mt m ^t = 1 − β1t vt v^t = 1 − β2t α θt = θt−1 − m ^t v^t + ϵ ここで、gt は現在の勾配、β1 と β2 はそれぞれモーメントの減衰率、α は学習率、ϵ は微小定数である 嚙み砕いた説明 Adamは、勾配降下法の一種で、学習の効率を上げるために勾配の履歴を利用する 勾配の平均と分散を考慮して、各パラメータの更新量を調整する これにより、学習が早く安定し、最適解に収束しやすくなる 実際の応用例 Adamは多くのディープラーニングフレームワークで標準的に使用されており、特に 画像認識や自然言語処理の分野でよく用いられる PyTorchを使用した実装例を以下に示す

import torch import torch.nn as nn import torch.optim as optim # モデルの定義 model = nn.Linear(10, 1) # 損失関数の定義 criterion = nn.MSELoss() # Adamオプティマイザの定義 optimizer = optim.Adam(model.parameters(), lr=0.001) # 入力データとターゲットデータの準備 inputs = torch.randn(32, 10) targets = torch.randn(32, 1) # 1エポックの学習ループ for epoch in range(100): # 勾配の初期化 optimizer.zero_grad() # 順伝播計算 outputs = model(inputs) # 損失の計算 loss = criterion(outputs, targets) # 逆伝播計算 loss.backward() # パラメータの更新 optimizer.step() # 損失の出力 print(f'Epoch {epoch+1}, Loss: {loss.item()}') このコードスニペットは単純な線形回帰モデルを使用し、Adamオプティマイザで学 習を行う例 PyTorchの optim.Adam クラスを使用することで、簡単にAdamアルゴリズムを実装可 能

Batch Processing 定義や意味 バッチ処理とは、一連のデータをまとめて処理する方法のことを指す。特に機械学習 やデータ処理の分野では、データセットを小さなグループ(バッチ)に分割し、それ らを一括して処理することを意味する。これにより、計算の効率を上げることができ る バッチサイズは、1回の処理で扱うデータの数を指し、トレーニング時間やメモリ使 用量に影響を与える 嚙み砕いた説明 バッチ処理は、例えば洗濯機に大量の洗濯物を一度に入れて洗うようなもの。洗濯物 を1枚ずつ洗うのではなく、まとめて洗うことで時間とエネルギーを節約する コンピュータでは、データを小分けにして計算することで、メモリの使用を効率化 し、計算を高速化することが可能になる 実際の応用例 バッチ処理は、特にディープラーニングのトレーニングプロセスにおいて頻繁に使用 される。PyTorchでは、データローダーを使用してデータをバッチ単位で提供するこ とができる 以下にPyTorchでのバッチ処理の例を示す:

import torch from torch.utils.data import DataLoader, TensorDataset # サンプルデータセットの作成(100個のサンプル、各サンプルは10の特徴を持つ) data = torch.randn(100, 10) labels = torch.randint(0, 2, (100,)) # データセットを作成 dataset = TensorDataset(data, labels) # バッチサイズを指定してデータローダーを作成 batch_size = 16 dataloader = DataLoader(dataset, batch_size=batch_size, shuffle=True) # バッチごとにデータを処理 for batch_data, batch_labels in dataloader: # ここでモデルのトレーニングを行う # 例えば: outputs = model(batch_data) print(batch_data.shape, batch_labels.shape) このコードでは、データセットを16個ずつのバッチに分けて処理してい る。 DataLoader はデータをシャッフルし、各エポックごとに異なる順序でバッチを提 供するため、モデルのトレーニングにおいて有効である バッチサイズを調整することで、トレーニングの速度やメモリ消費量を最適化するこ とが可能になる Data Augmentation 定義や意味 Data Augmentation(データ拡張)とは、既存のデータセットを増強する技術であ り、主に機械学習やディープラーニングの分野で用いられる。目的はモデルの汎化能 力を向上させることにある。具体的には、データの変換(例:回転、平行移動、スケ ーリング、反転など)を適用することにより、ニューラルネットワークがより頑健に データを学習できるようにする。 例えば、画像データに対するデータ拡張は以下のような変換を含む。 回転: Rθ (x) = [ cos θ sin θ − sin θ ]⋅x cos θ

平行移動: T(dx,dy) (x) = x + [ dx ] dy スケーリング: Ss (x) = s ⋅ x 嚙み砕いた説明 データ拡張は、モデルにとって「見たことのない」データを生成する方法。元のデー タセットを使って新しいデータを生み出し、モデルが異なる条件下でもパターンを見 つけられるようにする。たとえば、犬の画像を180度回転させれば、同じ犬の別の視 点をモデルに提示できる。 データ拡張は、特にデータセットが小さい場合や、収集が難しい場合に有用。多様な データを提供することで、モデルが過学習するのを防ぎ、より一般化された結果を得 られるようにする。 実際の応用例 画像分類タスクでのデータ拡張は非常に一般的で、特にConvolutional Neural Networks (CNNs) に対してよく使用される。PyTorchを使用する場 合、 torchvision.transforms モジュールがデータ拡張を容易にする。 以下はPyTorchを用いたデータ拡張の例。画像をランダムに回転、水平反転、正規化 する。

import torch from torchvision import datasets, transforms # 定義されたデータ拡張変換 data_transforms = transforms.Compose([ transforms.RandomHorizontalFlip(p=0.5), # 50%の確率で水平反転 transforms.RandomRotation(degrees=15), # ランダムに15度まで回転 transforms.ToTensor(), # テンソルに変換 transforms.Normalize((0.5, 0.5, 0.5), (0.5, 0.5, 0.5)) # 正規化 ]) # データセットの読み込みと変換の適用 train_dataset = datasets.CIFAR10(root='data', train=True, download=True, transform=data_ # データローダーの設定 train_loader = torch.utils.data.DataLoader(train_dataset, batch_size=32, shuffle=True) # モデル訓練時にデータ拡張が適用される for images, labels in train_loader: # 訓練用コード pass このコードスニペットでは、CIFAR-10データセットをロードし、ランダムな水平反 転、回転、及び正規化を行う。これにより、モデルはより多様な画像を訓練データと して受け取り、より良い汎化性能を得ることができる。 Custom Dataset 定義や意味 Custom Datasetとは、特に機械学習やディープラーニングの分野において、独自のデ ータセットを定義するためのクラスや機能のこと PyTorchにおいては、 torch.utils.data.Dataset クラスを継承してカスタムデータセ ットを作成することが一般的 カスタムデータセットは、データのロード、前処理、ラベル付けなどを含む一連の処 理を実装する データのサンプルを取得するために、 __len__ と __getitem__ の2つのメソッドを実装 する必要がある

嚙み砕いた説明 カスタムデータセットは、自分が持っているデータを使って機械学習モデルを訓練す るための準備をするためのもの PyTorchでは、データセットをカスタマイズして使うことで、画像やテキストなどの 様々なデータ形式を統一的に扱える 例えば、画像の分類をしたい場合、自分で撮影した写真をこのカスタムデータセット としてPyTorchで使えるようにする 実際の応用例 画像分類、テキスト分類、音声認識など、さまざまな機械学習タスクでカスタムデー タセットが使用される 以下に、PyTorchでのカスタムデータセットの簡単な実装例を示す

import torch from torch.utils.data import Dataset class CustomImageDataset(Dataset): def __init__(self, image_paths, labels, transform=None): """ Args: image_paths (list of str): List of file paths to images. labels (list of int): List of labels corresponding to each image. transform (callable, optional): Optional transform to be applied on a sample """ self.image_paths = image_paths self.labels = labels self.transform = transform def __len__(self): # Return the total number of samples return len(self.image_paths) def __getitem__(self, idx): # Load an image and its corresponding label image_path = self.image_paths[idx] image = self._load_image(image_path) label = self.labels[idx] # Apply transformations if any if self.transform: image = self.transform(image) return image, label def _load_image(self, path): # Here, you would include the code to load the image from the file path # For example, using PIL to open an image: from PIL import Image return Image.open(path) 上記のスニペットでは、 CustomImageDataset クラスを定義し、画像ファイルのパスと ラベルを引数として受け取る __len__ メソッドはデータセットのサイズを返し、 __getitem__ メソッドは指定され たインデックスに対応する画像とラベルを返す

画像に対する前処理(例えば、リサイズや正規化)は、 transform 引数を通じて任意 で適用可能 Transforms 定義や意味 トランスフォーム(Transforms)は、主にコンピュータビジョンやデータ前処理の文 脈で使用される手法であり、データセットに対してさまざまな操作を適用してデータ を変換することを指す これには、データの拡大・縮小、回転、ノイズの追加、正規化などの多様な操作が含 まれる 数学的には、トランスフォームは、元のデータセット X に操作 T を適用して新しい データセット X ′ を生成する操作として定義される: X ′ = T (X) 嚙み砕いた説明 トランスフォームは、データをより使いやすく、またはモデルのパフォーマンスを向 上させるために、データの形を変えるプロセス 例えば、画像データに対するトランスフォームでは、画像を回転させたり、サイズを 変更したり、明るさを調整したりする操作が含まれる 特にディープラーニングでは、データの多様性を増すためにトランスフォームを用い ることが多い 実際の応用例 PyTorchでは、トランスフォームを使用してデータの前処理やデータ拡張を行うこと が一般的 具体的な例として、 torchvision.transforms モジュールを使用して画像データに対す るトランスフォームを適用する 以下に、画像のトランスフォームを適用する例を示す

import torch from torchvision import transforms from PIL import Image # 画像の読み込み image = Image.open('path_to_image.jpg') # トランスフォームの定義 transform = transforms.Compose([ transforms.Resize((256, 256)), # 画像を256x256にリサイズ transforms.RandomHorizontalFlip(), transforms.ToTensor(), # 画像をランダムに左右反転 # 画像をテンソルに変換 transforms.Normalize(mean=[0.485, 0.456, 0.406], std=[0.229, 0.224, 0.225]) # 正規化 ]) # トランスフォームの適用 transformed_image = transform(image) # テンソルの形状を表示 print(transformed_image.shape) # 出力: torch.Size([3, 256, 256]) この例では、画像を256x256にリサイズし、ランダムに左右反転を行い、テンソルに 変換して正規化する一連のトランスフォームを適用 これにより、画像データがニューラルネットワークに適した形式に整えられる Forward Method 定義や意味 Forward Methodは、ニューラルネットワークにおける順伝播計算(forward propagation)を指す。これは入力データを受け取り、ネットワークを通じて出力を生 成する過程を含む。特に、深層学習フレームワークであるPyTorchでは、モデルクラ スの forward メソッドとして実装される。 順伝播計算において、入力ベクトル x に対して、非線形変換および線形変換を繰り返 すことで、出力ベクトル y を生成する。数式としては以下のように表される: y = f (x; W, b) ここで、W は重み行列、b はバイアスベクトル、f は活性化関数を含む変換関数を

示す。 嚙み砕いた説明 Forward Methodは、ニューラルネットワークにデータを流し込み、最終的な予測を得 るための手続き。例えば、画像認識のタスクにおいて、画像データをネットワークに 入力し、猫や犬などのラベルを出力する。 具体的には、ネットワークの各層を通してデータが変換され、最終層でそのデータが 判定や分類に用いられる。 実際の応用例 PyTorchにおけるニューラルネットワークの実装で使用され、モデルの推論を行う際 に不可欠なメソッド。 以下に、PyTorchを用いた簡単なニューラルネットワークモデルでの forward メソッ ドの実装例を示す。

import torch import torch.nn as nn import torch.nn.functional as F # ニューラルネットワークモデルの定義 class SimpleNet(nn.Module): def __init__(self): super(SimpleNet, self).__init__() # 線形層の定義 self.fc1 = nn.Linear(784, 128) # 784次元の入力を128次元に変換 self.fc2 = nn.Linear(128, 64) # 128次元の入力を64次元に変換 self.fc3 = nn.Linear(64, 10) # 64次元の入力を10次元に変換(10クラス分類) def forward(self, x): # 順伝播の処理 x = F.relu(self.fc1(x)) # 活性化関数ReLUの適用 x = F.relu(self.fc2(x)) x = self.fc3(x) # 出力層では通常活性化関数を適用しない return x # モデルのインスタンス化 model = SimpleNet() # ダミーの入力データ(28x28ピクセルの画像を1次元にフラット化) dummy_input = torch.randn(1, 784) # バッチサイズ1の例 # 順伝播の実行(予測の生成) output = model(dummy_input) print(output) この例では、入力データを3層の順に通過させ、最終的な分類結果を出力す る。 forward メソッド内で、各層に対する計算が実行され、最終的に出力が得られ る。 Backward Method 定義や意味 Backward Methodは、ニューラルネットワークの訓練における重要なステップであ り、誤差逆伝播法(Backpropagation)を用いてネットワークの重みを更新するプロ セス

ニューラルネットワークの出力と正解ラベルとの間の損失を計算し、その損失が最小 となるように重みを調整する ∂E 数式としては、誤差関数 E に対して、重み w の勾配を計算するための偏微分 ∂w を 求める過程 PyTorchでは、 backward() メソッドを使用して自動微分を行い、計算グラフを逆方向 に辿ることで勾配を計算する 嚙み砕いた説明 ニューラルネットワークが「学習」するためには、予測の誤差を基にしてモデルの重 みを少しずつ調整する必要がある。そのために、誤差をどのように重みが影響してい るかを解析し、その影響度に応じて重みを更新する Backward Methodはこの調整を行うもので、ネットワークの出力層から入力層に向か って、誤差の勾配を計算しながら重みの更新量を決定する 具体的には、ネットワークに入力を与え、出力を得る。出力と正解ラベルを比較して 損失を計算し、その損失を用いて重みを更新する方向を見つける 実際の応用例 ニューラルネットワークの訓練において、モデルがデータからパターンを学習する際 に使用される PyTorchを用いた実装例を以下に示す

import torch import torch.nn as nn import torch.optim as optim # シンプルな線形回帰モデル model = nn.Linear(1, 1) criterion = nn.MSELoss() # 損失関数として平均二乗誤差を使用 optimizer = optim.SGD(model.parameters(), lr=0.01) # 確率的勾配降下法を使用 # ダミーデータ inputs = torch.tensor([[1.0], [2.0], [3.0]], requires_grad=True) targets = torch.tensor([[2.0], [4.0], [6.0]]) # フォワードパス outputs = model(inputs) loss = criterion(outputs, targets) # バックワードパス loss.backward() # 勾配計算 # 勾配を用いて重みを更新 optimizer.step() # 勾配をゼロに戻す optimizer.zero_grad() このコードスニペットでは、PyTorchを使って線形回帰モデルを訓練する過程を示 し、 backward() メソッドで勾配を計算し、 optimizer.step() で重みを更新している loss.backward() の呼び出しによって、各パラメータの勾配が計算さ れ、 optimizer.step() がそれを使ってパラメータを更新する